Społeczność SpeakLeash.org, która pracuje nad polskimi LLM (Large Language Models), opublikowała w serwisie Hugging Face zestawienie “Open PL LLM Leaderboard”. Jest to ranking dużych modeli językowych open-source na podstawie zadań w języku polskim. Benchmark ten ma pomóc badaczom w lepszym określaniu potencjału poszczególnych modeli w zależności od testowanego obszaru.

Metodologia rankingu Open PL LLM Leaderboard

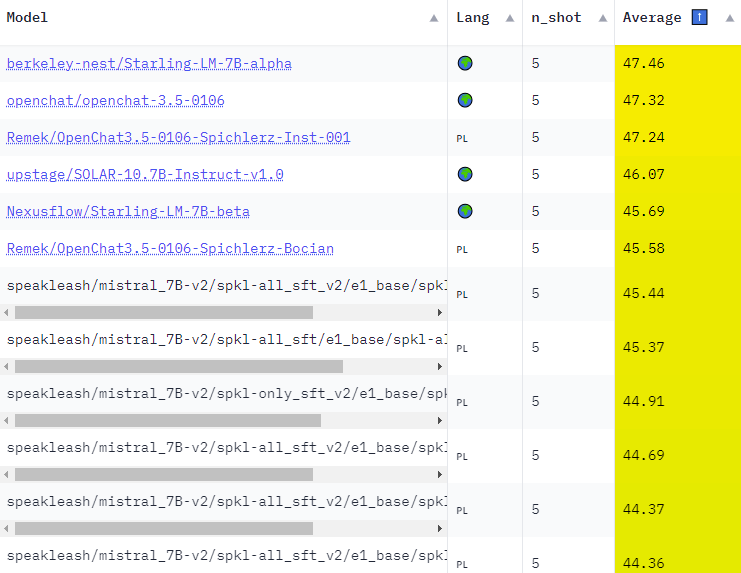

Zadania, którym zostały poddane modele, testują ich zdolność rozumienia języka polskiego, generowania tekstu oraz odpowiadania na podstawowe pytania. Testy porównawcze zostały wykonane w oparciu o dwie metody 0-shot (bez podawania przykładów) i 5-shot (z podanym schematami zadanie-odpowiedź). Jak można przewidzieć, wynik w metodzie 5-shot w większości modeli wypada lepiej. Większość zadań ma dwie wersje, pierwsza, która wymaga wygenerowania odpowiedzi przez LLM, a druga sprawdzająca zdolności wyboru spośród dostępnych opcji. Na tę chwilę, modele są testowane bez użycia ich szablonów.

Duże modele językowe biorące udział w rankingu Open PL LLM

Duże modele językowe open-source biorące udział w badaniu, można podzielić na polskie i wielojęzyczne. Warte odnotowania są też modele eksperymentalne autorstwa SpeakLeash.org.

Polskie modele:

- speakleash/Bielik-7B-Instruct-v0.1,

- speakleash/Bielik-7B-v0.1,

- Azurro/APT3-1B-Base,

- Azurro/APT3-1B-Instruct-v1,

- Voicelab/trurl-2-7b,

- Voicelab/trurl-2-13b-academic,

- OPI-PG/Qra-1b,

- OPI-PG/Qra-7b,

- OPI-PG/Qra-13b,

- szymonrucinski/Curie-7B-v1,

- sdadas/polish-gpt2-xl.

Modele wielojęzyczne:

- meta-llama/Llama-2-7b-chat-hf,

- mistralai/Mistral-7B-Instruct-v0.1,

- HuggingFaceH4/zephyr-7b-beta,

- HuggingFaceH4/zephyr-7b-alpha,

- internlm/internlm2-chat-7b-sft,

- internlm/internlm2-chat-7b,

- mistralai/Mistral-7B-Instruct-v0.2,

- teknium/OpenHermes-2.5-Mistral-7B,

- openchat/openchat-3.5-1210,

- Nexusflow/Starling-LM-7B-beta,

- openchat/openchat-3.5-0106,

- berkeley-nest/Starling-LM-7B-alpha,

- upstage/SOLAR-10.7B-Instruct-v1.0,

- meta-llama/Llama-2-7b-hf,

- internlm/internlm2-base-7b,

- mistralai/Mistral-7B-v0.1,

- internlm/internlm2-7b,

- alpindale/Mistral-7B-v0.2-hf,

- internlm/internlm2-1_8b.

Autorzy zachęcają do uzupełnienia zestawienia o inne modele, muszą one jednak spełniać określone wymagania, które umożliwią obiektywne porównanie z pozostałymi.

Współpraca SpeakLeash.org z Cyfronetem AGH

SpeakLeash.org (a.k.a Spichlerz) podkreśla, że do stworzenia rankingu korzystania z języka polskiego przez duże modele językowe, przyczyniła się ścisła współpraca z Akademickim Centrum Komputerowym Cyfronet AGH. Cyfronet wspierał społeczność w szkoleniu, testowaniu i dostrajaniu modeli. Przy tak dużych testach, niezbędna jest ogromna moc obliczeniowa – centrum komputerowe Akademii Górniczo-Hutniczej w Krakowie dysponuje m.in. superkomputerem Helios o teoretycznej mocy obliczeniowej 35 PetaFlopsów.

Polski LLM na horyzoncie

Niezależnie od tego, kiedy doczekamy się wdrożenia w życie modelu PLLuM, temat otwartych dużych modeli językowych będzie nabierał na znaczeniu. Tendencja do tworzenia mniejszych modeli AI wyspecjalizowanych w wąskiej dziedzinie jest coraz bardziej widoczna. Stworzenie benchmarku LLM dla języka polskiego jest ogromnym wsparciem dla polskiej społeczności AI, w szczególności badaczy i developerów. Teraz modele będzie można porównać w analogicznym zestawie testowym. Ranking o którym mowa, możesz znaleźć tutaj.