Sztuczna inteligencja to dziedzina, która od dziesięcioleci inspiruje naukowców i twórców. W jej historii zapisało się pełno przełomowych odkryć, wybitnych umysłów i niezwykłych osiągnięć techniki.

Sztuczna inteligencja przeszła długą drogę od pierwszych koncepcji w latach 50. ubiegłego wieku do współczesnych, zaawansowanych systemów. Alan Turing, John McCarthy czy Marvin Minsky to pionierzy, którzy stworzyli fundamenty pod rozwój sztucznej inteligencji. Przełomowe projekty, takie jak program do gry w warcaby Arthura Samuela czy ELIZA Josepha Weizenbauma, ukazały potencjał maszyn w naśladowaniu ludzkiej inteligencji. Mimo że entuzjazm lat 60. został przyhamowany przez odkrycie ograniczeń perceptronów, badania nad sieciami neuronowymi i uczeniem maszynowym były kontynuowane. Obecnie AI osiąga imponujące rezultaty w wąskich dziedzinach, a inwestycje i innowacje napędzają jej nieustanny rozwój. Wyzwaniem pozostaje stworzenie systemów o szerokiej inteligencji, potrafiących adaptować się do różnorodnych zadań. Historia sztucznej inteligencji to pouczający temat, który mówi wiele o ludzkiej pomysłowości i dążeniu do przekraczania granic możliwości maszyn.

Krótka historia sztucznej inteligencji – ważne daty dla technologii AI

Jeżeli interesują Cię konkretne wydarzenia, poniższa lista w formie osi czasu, przybliży Ci historię rozwoju sztucznej inteligencji.

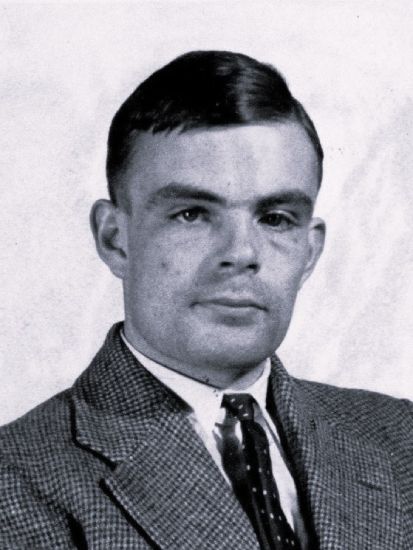

- 1950 – Alan Turing opublikował artykuł „Computing Machinery and Intelligence”, w którym zaproponował test inteligencji maszyn (późniejszy Test Turinga).

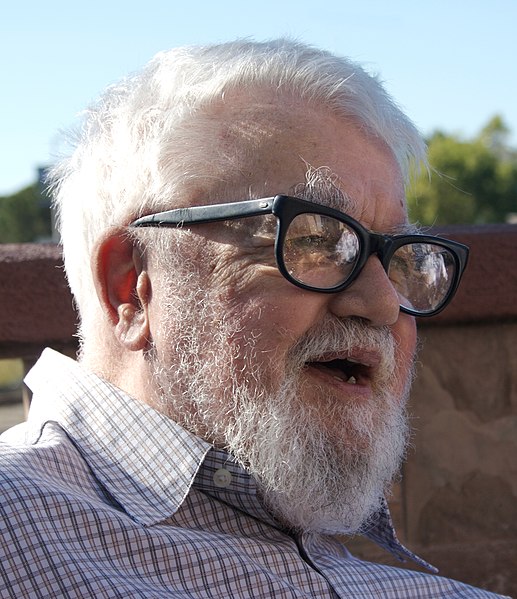

- 1951 – Marvin Minsky zbudował Snarc, pierwszą w historii maszynę wykorzystującą sieci neuronowe.

- 1955 – John McCarthy podczas warsztatów w Dartmouth (Dartmouth college) jako pierwszy używa terminu „sztuczna inteligencja”.

- 1952 – Informatyk Arthur Samuel stworzył swój samouczący się algorytm gry w warcaby.

- 1956 – Allen Newell, Herbert A. Simon, oraz Cliff Shaw tworzą program komputerowy Logic Theorist, który był opisywany jako „pierwszy program sztucznej inteligencji”.

- 1958 – Arthur Samuel podczas przemówienia, w którym opowiadał o uczeniu maszyn gry w szachy, użył terminu „Machine learning” (uczenie maszynowe).

- 1959 – John McCarthy stworzył język programowania LISP.

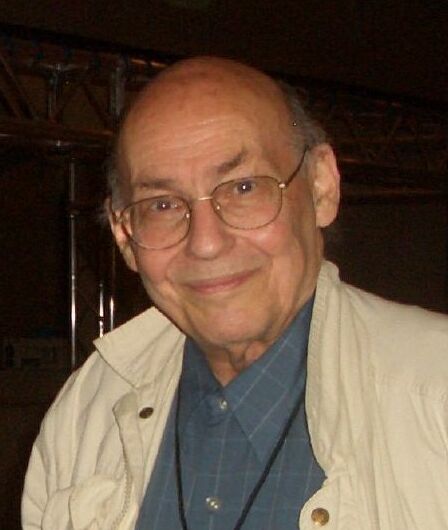

- 1966 – Joseph Weizenbaum stworzył ELIZĘ, program, który symulował konwersację z człowiekiem.

- 1974 – Zima AI, która była skutkiem wstrzymania finansowania na badania.

- 1983 – Powstaje firma Thinking Machines Corporation, producent superkomputerów, która jest uważana za pierwszą firmę AI.

- 1997 – Garri Kasparow przegrywa mecz szachowy z IBM Deep Blue.

- 2000 – Powstaje Kismet, pierwszy robot symulujący ludzkie emocje za pomocą twarzy.

- 2001 – Google zaczyna używać systemów uczących się do sprawdzania pisowni w wyszukiwarce.

- 2005 – Pierwszy autonomiczny samochód przejechał ponad 200 kilometrów przez pustynie.

- 2011 – Watson, czyli system komputerowy stworzony przez IBM, bierze udział w teleturnieju Jeopardy. Wykorzystując NLP (Natural Language Processing) pokonuje dotychczasowych mistrzów gry z dużą przewagą. W tym samym roku Apple prezentuje asystenta głosowego Siri.

- 2016 – AlphaGo, jako pierwszy program AI pokonał mistrza świata w grze Go.

- 2019 – Algorytm DeepCubeA układa kostkę Rubika w 1,2 sekundy.

Początki sztucznej inteligencji – lata 50. XX wieku

Lata pięćdziesiąte XX wieku były okresem, w którym zarysowały się fundamenty sztucznej inteligencji. W tym czasie Alan Turing, wybitny brytyjski matematyk, zaprezentował światu ideę maszynowej inteligencji, która później ewoluowała w Test Turinga. W 1952 roku Arthur Samuel przedstawił program do gry w warcaby, zaskakujący zdolnością do samokształcenia. Natomiast w 1955 roku, podczas warsztatów na Uniwersytecie Dartmouth, John McCarthy jako pierwszy użył terminu „sztuczna inteligencja”, rozpoczynając nową erę badań. W tym samym okresie (1956) przez trio Newell, Shaw i Simon, został opracowany Logic Theorist, który zyskał miano pionierskiego programu AI. Wspomniane wydarzenia i postacie, wyznaczyły kierunek rozwoju technologii SI na kolejne dekady.

Rozwój sztucznej inteligencji w latach 1957-1979

Ten przedział historii sztucznej inteligencji, to okres dynamicznego rozwoju tej technologii. Był to także czas, gdy w 1974 roku nastała tzw. zima sztucznej inteligencji, czyli okres zmniejszonego finansowania i zainteresowania badaniami nad AI.

Twórcze lata 50. i 60. XX wieku

W latach pięćdziesiątych i sześćdziesiątych ubiegłego stulecia, SI zaczęła nabierać realnych kształtów. Po wprowadzeniu tego terminu przez McCarthy-ego, świat nauki zyskał nowe narzędzie – język programowania LISP, który zrewolucjonizował badania w tej dziedzinie. Rok później, w 1959, Arthur Samuel zdefiniował pojęcie uczenia maszynowego, torując drogę do rozwoju algorytmów zdolnych do samokształcenia. AI zaczęła przenikać do popkultury, stając się tematem książek i filmów, a pełni optymizmu naukowcy, przewidywali rychłe osiągnięcie przełomu w tworzeniu maszyn o ludzkiej inteligencji. Takie założenie przyciągnęło znaczne fundusze na dalsze badania.

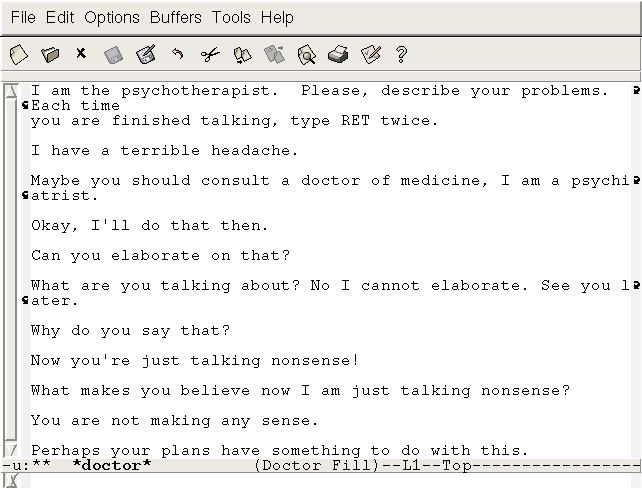

ELIZA – program symulujący rozmowę

W 1966 roku Joseph Weizenbaum stworzył ELIZĘ, program, który zrewolucjonizował postrzeganie możliwości komputerów. ELIZA nie była zaawansowanym systemem AI, ale potrafiła prowadzić prostą konwersację, imitując terapeutę. Ten przełomowy projekt stał się kamieniem milowym w dziedzinie przetwarzania języka naturalnego i udowodnił, że maszyny mogą komunikować się z ludźmi w sposób, który wydawał się dotąd domeną człowieka.

Perceptrony – ważny kamień milowy w historii AI

Perceptrony zostały szczegółowo opisane w artykule przez Franka Rosenblatt-a w 1958 roku i były pierwszym krokiem w kierunku rozwoju sieci neuronowych oraz uczenia maszynowego. Te wczesne modele algorytmiczne, choć ograniczone, zapoczątkowały badania nad rozpoznawaniem wzorców. Entuzjazm, który wywołały, został ostudzony przez odkrycie ich ograniczeń, co przyczyniło się do spowolnienia badań w tej dziedzinie. Niemniej jednak perceptrony pozostają ważnym elementem historii AI jako prekursorzy dzisiejszych zaawansowanych sieci neuronowych.

Lata współczesne i kolejne wyzwania sztucznej inteligencji

W ostatnich kilku latach sztuczna inteligencja poczyniła znaczące postępy, szczególnie w dziedzinie wąskiej AI, która skupia się na specyficznych zadaniach. Każdego dnia dowiadujemy się o nowym zastosowaniu tej technologii i już nikogo nie dziwi, że systemy komputerowe potrafią w wielu zadaniach przewyższyć ludzi wydajnością i precyzją. W kontekście niesamowitych osiągnięć, warto wspomnieć o możliwościach jakie zaprezentowała niedawno firma Neuralink. Podczas transmisji na żywo, pokazała możliwości swojego chipu, za pomocą którego sparaliżowana osoba grała na komputerze w szachy, sterując grą za pomocą myśli.

Rozwój, dostępność i możliwości narzędzi opartych na SI, wpływają na wzrost jej popularności. Jeżeli dysponujemy odpowiednimi zasobami mocy obliczeniowej lub środkami na ich dzierżawę, to nic nie stoi na przeszkodzie, żeby wykorzystać możliwości otwartych modeli AI w domowym zaciszu. Kolejnym, ogromnym krokiem będzie stworzenie ogólnej sztucznej inteligencji (AGI) zdolnej uczyć się i rozwiązywać dowolne problemy podobnie jak człowiek. Elon Musk twierdzi, że stanie się to już w 2026 roku, a ważną rolę będzie ogrywała odpowiednia dostępność energii elektrycznej. Zanim to jednak nastąpi musimy dostosować się do obecnej rewolucji technologicznej pod kątem edukacyjnym, prawnym i etycznym.